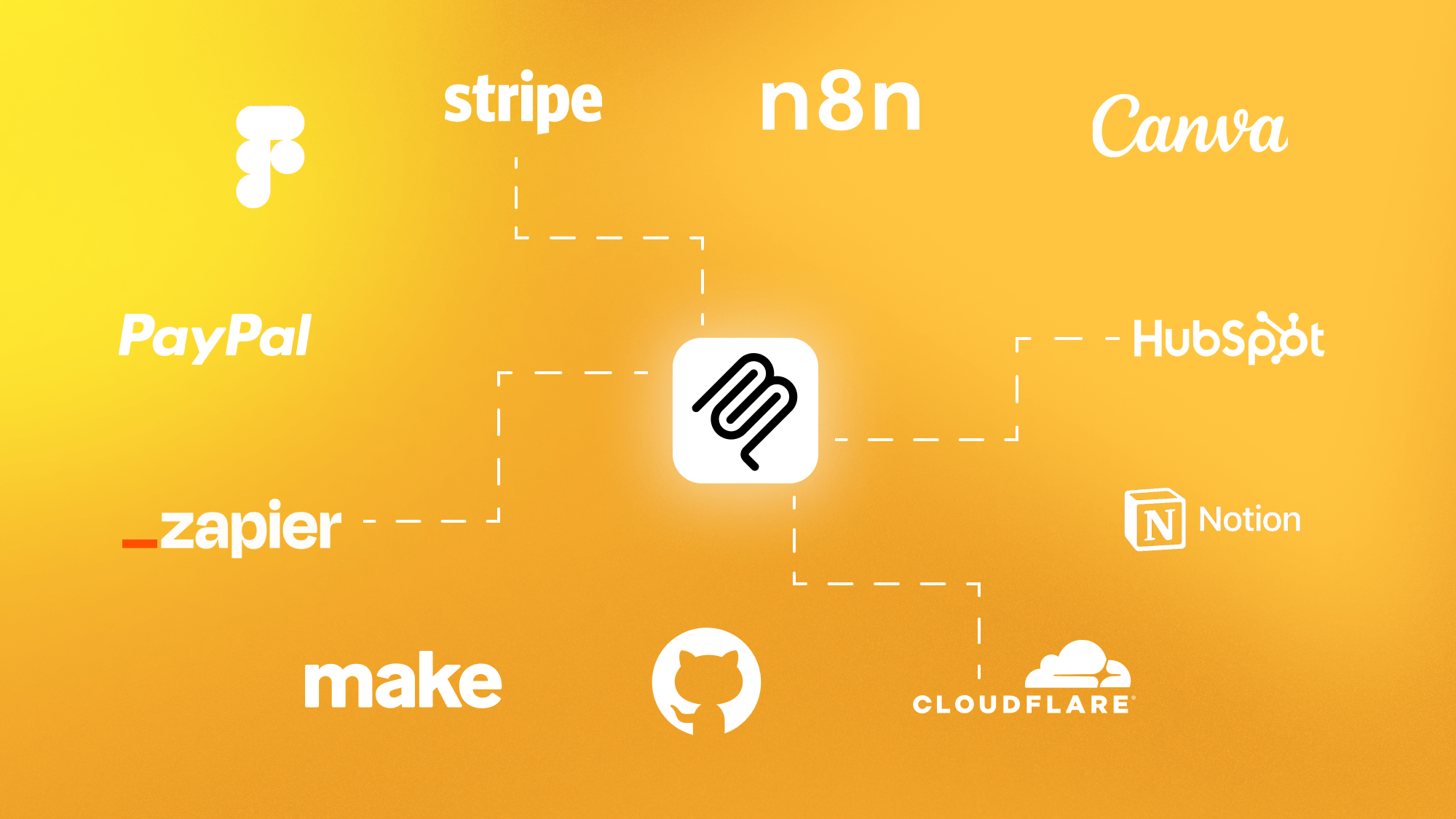

Ob Datenbank-Update, Ticket-Erstellung oder Zahlungsabwicklung – die nächsten Abschnitte zeigen dir 15 MCP-Server, mit denen ein KI-Sprachmodell solche Aufgaben per Befehl in natürlicher Sprache übernimmt. Jeder Steckbrief erklärt in wenigen Sätzen, welche Aktionen der jeweilige Server freischaltet und wofür er sich besonders eignet.

Bevor du in die Liste der MCP-Server eintauchst, lohnt sich ein Blick in unseren ausführlichen Artikel zum Model Context Protocol. Er beschreibt, wie ein einziges Manifest Sprachmodelle sicher mit externen Diensten verbindet. Mit diesem Hintergrund fällt es leichter, in der folgenden Übersicht den passenden Server für deinen Tech-Stack auszuwählen.

Alle hier vorgestellten Instanzen sind offizielle MCP-Server. Sie werden direkt von den jeweiligen Dienstanbietern entwickelt, gewartet und stets parallel zu ihren Original-APIs aktualisiert. So bleiben Endpunkte, Auth-Verfahren und Rate-Limits identisch mit der Live-Plattform und geeignet für produktive Workflows, während Community- oder reine Referenzserver meist nur Demozwecke erfüllen und weniger regelmäßig gepflegt werden.

Zapier

Zapier betreibt einen vollständig gehosteten MCP-Server, der deinem Sprachmodell direkten Zugriff auf über 7.000 Apps und mehr als 30.000 Aktionen verschafft. Nach dem Anlegen eines individuellen Endpunkts autorisierst du die jeweils benötigten Apps per OAuth oder API-Key; Zapier übernimmt dabei das komplette Auth-Handling und setzt in der Beta feste Ratelimits von 300 Aufrufen pro Monat. Jeder Tool-Aufruf liefert eine strukturierte JSON-Antwort, sodass du Nachrichten versenden, Datensätze anlegen oder Termine buchen kannst, ohne eigene Integrationen zu schreiben. Damit wird Zapier MCP zum flexiblen Orchestrierungslayer für produktive Workflows, ganz ohne zusätzliche Infrastruktur auf deiner Seite.

Zapier MCP Demo: Connect AI Assistants to Nearly 8,000+ Apps Effortlessly!

Make

Make betreibt einen cloudbasierten MCP-Server, der jedes von dir freigegebene Szenario als eigenständiges Tool zur Verfügung stellt. Sobald du ein Zugriffstoken generiert hast, tauchen genau diese Szenarien als ausführbare Aktionen im Manifest auf. Ein automatisierter Lead-Flow kann damit etwa Daten prüfen, CRM-Einträge anlegen und Benachrichtigungen verschicken. Während eines Laufs werden alle Log-Einträge in Echtzeit im Browser angezeigt, sodass sich jeder Zwischenschritt nachvollziehen lässt. Die Plattform skaliert die Ausführung bis zur in deinem Tarif vorgesehenen Parallel-Run-Grenze automatisch und bietet feingranulare Zugriffsrechte, damit nur autorisierte Szenarien veröffentlicht werden. So bleibt deine Automatisierung transparent, kontrollierbar und jederzeit erweiterbar, ohne dass du dich um Infrastruktur kümmern musst.

n8n

n8n bringt seit Version 1.88.0 MCP-Support nativ mit. Aktivierst du im Workflow den MCP Server Trigger, erzeugt n8n eine eindeutige Zugriffs-URL samt Token und stellt alle als Tool-Node markierten Schritte deines Workflows im Manifest bereit. Ein solcher Workflow kann offene Aufgaben abrufen, Daten transformieren und in eine Datenbank schreiben, während das Sprachmodell die Orchestrierung übernimmt. Ausführungen werden in Echtzeit im Editor angezeigt und lassen sich debuggen oder neu starten. Bei Self-Hosting bleiben deine Daten komplett in deiner Infrastruktur; wählst du n8n Cloud, liegen sie in der von n8n verwalteten Umgebung. Zugriffsrechte definierst du pro Workflow, sodass sich präzise steuern lässt, welche Automatisierungen öffentlich verfügbar sind.

Cloudflare

Cloudflare stellt eine Suite von MCP-Servern bereit, darunter Dienste für DNS-Analysen, Workers-Observability, KV-Storage, Logpush und eine Dokumentationssuche. Mit einem passend gescopten API- oder OAuth-Token lassen sich diese Werkzeuge mit niedriger Latenz über das globale Cloudflare-Netzwerk aufrufen. Das Modell kann so Logs abrufen, neue Namespaces anlegen oder Konfigurationsbeispiele beziehen. Die Antworten folgen dem JSON-RPC-2.0-Format; bei Log-Abfragen enthalten sie Edge-Zeitstempel, was das Troubleshooting erleichtert. Granulare Token-Scopes verhindern unerwünschte Änderungen, und die weltweite Infrastruktur von Cloudflare sorgt selbst bei Lastspitzen für eine stabile Erreichbarkeit.

Build your own remote MCP Server with Cloudflare

Linear

Linear erweitert sein schnelles Projektmanagement um einen offiziellen MCP-Server. Nach OAuth-Autorisierung stehen Tools wie find_issues (Suche), create_issue (Anlegen) und update_issue (Ändern) zur Verfügung, die Parameter wie Titel, Beschreibung und Priorität akzeptieren. Damit kann ein Sprachmodell Tickets erstellen, filtern oder aktualisieren, während Linear jede Aktion im Issue-Verlauf protokolliert. Die Antworten werden über einen Streaming-Endpoint ausgegeben, sodass Resultate bereits während der Ausführung eintreffen. OAuth-Scopes begrenzen dabei den Schreib- und Admin-Zugriff.

PayPal

PayPal betreibt einen MCP-Server für Händler:innenprozesse. Nach erfolgreicher OAuth-Autorisierung zeigt der Server nur die Tools an, für die das Token die entsprechenden Scopes besitzt, etwa um Rechnungen zu erstellen oder Zahlungen zu erstatten. Jede Transaktion erhält eine eindeutige Referenz-ID, und die Antwort wird per Streaming-Endpoint sofort an das aufrufende Modell übertragen. Die Scope-basierten Tokens begrenzen den Zugriff strikt auf freigegebene Aktionen und verhindern so ungewollte Abbuchungen. Zur späteren Prüfung stellt PayPal revisionssichere Audit-Reports bereit, die sämtliche Finanzvorgänge über mehrere Jahre nachvollziehbar machen.

Overview of the PayPal MCP server

Notion

Notion testet derzeit einen gehosteten MCP-Server. Nach OAuth-Autorisierung stellt der Server nur die Seiten und Datenbanken als Tools bereit, die deiner Integration ausdrücklich freigegeben wurden. Die Antworten kommen in einem kompakten, Markdown-basierten Schema und enthalten Block-IDs, sodass ein Modell einzelne Elemente präzise referenzieren und bearbeiten kann. Verfügbare Befehle reichen von Seite anlegen über Datenbank-Einträge schreiben bis Inhalte durchsuchen. Änderungen landen nach kurzer Zeit im Version History-Log von Notion, und weil Integrationen nur auf freigegebene Bereiche zugreifen dürfen, bleiben vertrauliche Daten verborgen.

GitHub

GitHub betreibt einen offiziellen MCP-Server, über den sich Pull-Requests, Issues, GitHub Actions und Repository-Inhalte per Toolset ansprechen lassen. Nach Authentifizierung mit einem Personal-Access-Token stehen Befehle wie pull_requests.list, issues.create, actions.dispatch_workflow oder repos.search_files bereit. Die Antworten werden im JSON-RPC-2.0-Format geliefert und enthalten Statusangaben, Reviewer-Informationen sowie Zeitstempel. Mithilfe der Toolset-Option lässt sich der verfügbare Funktionsumfang gezielt auf bestimmte Bereiche beschränken, was die Angriffsfläche reduziert. Tools wie list_workflow_jobs und get_job_logs stellen zudem Prüf- und Logdaten bereit, die sich während der Ausführung parallel auswerten lassen.

Introducing the GitHub MCP Server: AI interaction protocol | GitHub Checkout

Supabase

Der Supabase-MCP-Server macht Postgres-Datenbanken sowie – je nach Implementierung – Auth- und Storage-Ressourcen eines Supabase-Projekts für LLM-Clients unmittelbar nutzbar. Nach der Authentifizierung per Personal-Access-Token liest der Server das Datenbankschema (und bei Community-Servern auch Benutzer- bzw. Bucket-Informationen) ein und stellt mehr als 20 standardisierte Tools bereit. Damit lassen sich Tabellen anlegen, SQL-Abfragen ausführen, Projekte pausieren bzw. reaktivieren und Logs abrufen – ohne das Supabase-Dashboard zu öffnen.

Introducing the official Supabase MCP Server

Stripe

Der Stripe-MCP-Server macht Zahlungs-, Kund:innen-, Produkt- und Abo-Funktionen der Stripe-API direkt für LLM-Agenten nutzbar. Nach Authentifizierung mit einem restricted API-Key stehen Tools wie paymentIntents.create, customers.list, subscriptions.update oder products.read bereit. Die Serverantworten werden im JSON-RPC-2.0-Format geliefert und enthalten dieselben Felder (id, amount, currency u. a.) wie die zugehörigen Stripe-Objekte. Zusätzlich stellt das Tool documentation.read Ausschnitte aus der Stripe-Dokumentation bereit, sodass Codebeispiele ohne Kontextwechsel abrufbar sind.

Working with the Stripe MCP server and AI Assistant in VS Code

Figma Dev Mode

Figma stellt im Dev Mode einen lokal laufenden MCP-Server bereit, der ausgewählte Design-Frames für Sprachmodelle zugänglich macht. Nach der Aktivierung können Tools den zugehörigen React-mit-Tailwind-Code oder die in einem Frame verwendeten Design-Variablen abrufen. Die Antworten enthalten den node-ID-Verweis, Tailwind-Klassen und Token-Werte, sodass Modelle einzelne Elemente eindeutig identifizieren und weiterverarbeiten können. Da der Server im Desktop-Client ausgeführt wird, verbleiben diese Metadaten zunächst auf dem eigenen Rechner und werden nur übertragen, wenn sie aktiv an ein Modell gesendet werden. Dev Mode verkürzt den Weg von Design zu lauffähiger Oberfläche und reduziert Kontextwechsel drastisch.

Create code from designs with the Dev Mode MCP server | Figma

DeepL

DeepL stellt eine Referenz-Implementierung eines MCP-Servers bereit, die Übersetzungen und Paraphrasen nahtlos in LLM-Workflows einbindet. Nachdem du einen DeepL-API-Schlüssel hinterlegt hast, veröffentlicht der Server Werkzeuge für Textübersetzung, Sprachlistenabfrage und Umformulierung. Beim Übersetzen kannst du Text, eine gewünschte Formalitätsstufe sowie optional eine Glossar-ID übergeben. Die Antworten folgen dem JSON-RPC-2.0-Format und können auf Wunsch ein Feld mit den abgerechneten Zeichen enthalten, während Informationen zum verbleibenden Monatskontingent über ein separates Usage-Tool abgerufen werden. Auf diese Weise lassen sich DeepL-Funktionen ohne zusätzlichen Integrationsaufwand in automatisierte Abläufe einbetten.

Firecrawl

Firecrawl vereint Suche, Scraping und Link-Crawling in einem MCP-Server, der Webdaten strukturiert ausliefert. Sobald ein API-Schlüssel hinterlegt ist, stehen Tools für das Scrapen einzelner Seiten, Batch-Aufträge, Web-Suchabfragen und Crawling bereit. Die Antworten enthalten je nach Tool Roh-HTML, extrahierten Text oder gerendertes Markdown sowie Metadaten wie den Seitentitel und Autor- oder Datumsangaben. Durch konfigurierbare Parameter für Tiefe, Rate-Limits und Timeouts behältst du die Kosten im Griff, während Webhook-Events über den Fortschritt langer Crawl-Jobs informieren. Damit kann ein Modell aktuelle Webinhalte abrufen und seine Antworten mit frischen Quellen untermauern.

HubSpot

HubSpot öffnet sein Smart CRM für MCP-Server. Nachdem Token-Scopes definiert sind, stehen Werkzeuge bereit, um Kontakte, Deals, Tickets und Aufgaben abzurufen, zu erstellen oder zu aktualisieren sowie Assoziationen zu verwalten. Das Modell fasst offene Deals zusammen oder legt neue Kontakte an, jede Änderung landet sofort im CRM-Verlauf. Aufrufe außerhalb der gewährten Rechte werden verweigert. Vertrieb, Marketing und Support verschmelzen so in einer sprachgesteuerten Oberfläche, und konsistente Kundendaten bleiben zentral.

Perplexity

Perplexity bietet einen MCP-Server an, der die Sonar Search API als Echtzeit-Recherchetool bereitstellt. Das Modell stellt Suchanfragen, strukturiert Ergebnisse und reichert sie mit Zitaten an, sodass Antworten fundiert und überprüfbar werden. Metadaten wie Quelle und Veröffentlichungsdatum kommen als kompakte JSON-Struktur. Rate- und Budget-Limiten verhindern exzessive Nutzung. Perplexity ersetzt statisches Training durch aktuelle Webinformationen, schafft Vertrauen bei professionellen Nutzerinnen und Teams.

Canva

Canva liefert einen MCP-Server, der dein Designarchiv nicht nur durchsucht, sondern auch direkt im Chat neue Entwürfe erstellt und vorhandene anpasst. Nach OAuth erscheinen zwei Toolgruppen: eine für Recherche und Zusammenfassungen deiner Präsentationen, Docs und Kampagnen-Assets sowie eine zweite für Aktionen wie Präsentationen anlegen, Assets umformatieren oder Designs aktualisieren. Ein kurzer Prompt wie „Erstelle ein Pitch Deck aus diesem Gespräch“ legt sofort eine neue Präsentation in deinem Workspace an.

Fazit

Die wahre Power von MPC-Servern zeigt sich in der Kombination, z.B. kannst du mehrere dieser an Claude Desktop anschließen und dir damit einen KI-Assistenten bauen, der dir Fragen beantwortet und Aufgaben für dich erledigt. Sobald Analyse, Datenhaltung, Automatisierung und Gestaltung als eigenständige Tools im Manifest auftauchen, orchestriert dein Sprachmodell komplette Workflows in einem einzigen Dialog. Statt zwischen Apps zu wechseln, beschreibst du nur noch das Ziel, und der Assistent ruft die passenden Endpunkte auf, fasst Ergebnisse zusammen und liefert das fertige Artefakt. So verwandelt das Model Context Protocol unterschiedliche Dienste in ein modulares Ökosystem, das mit jedem neuen Server wächst und Routineprozesse spürbar verkürzt.